¿Cuál es la mejor IA? El caso de Grok 3 y el problema de los benchmarks

Para decidir cuál es el mejor modelo de IA no basta con mirar las comparativas. Es necesario conocer las necesidades que tenemos y qué coste estamos dispuestos a asumir para cubrirlas.

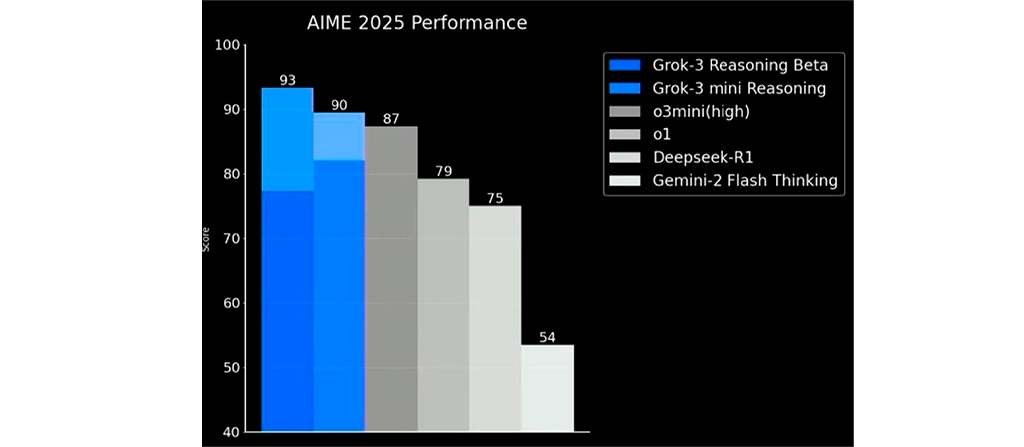

A mediados de febrero se presentó Grok 3, el modelo de inteligencia artificial generativa de xAI, la empresa de IA de Elon Musk. Grok 3 fue anunciado a bombo y platillo como el mejor modelo de IA hasta el momento. Uno de los gráficos que acompañaba a su lanzamiento así lo atestiguaba:

Se trata del benchmark AIME, que mide los resultados obtenidos en uno de los exámenes de acceso a las Olimpiadas de Matemáticas de EEUU y en el que, aparentemente, Grok 3 sobresale sobre el resto de sus competidores. Sin embargo, el modelo de xAI es el único que presenta dos tonalidades en el gráfico. Eso se debe a que, mientras que la parte más oscura representa su primera respuesta, la parte más clara muestra la respuesta más común entre 64 intentos diferentes.

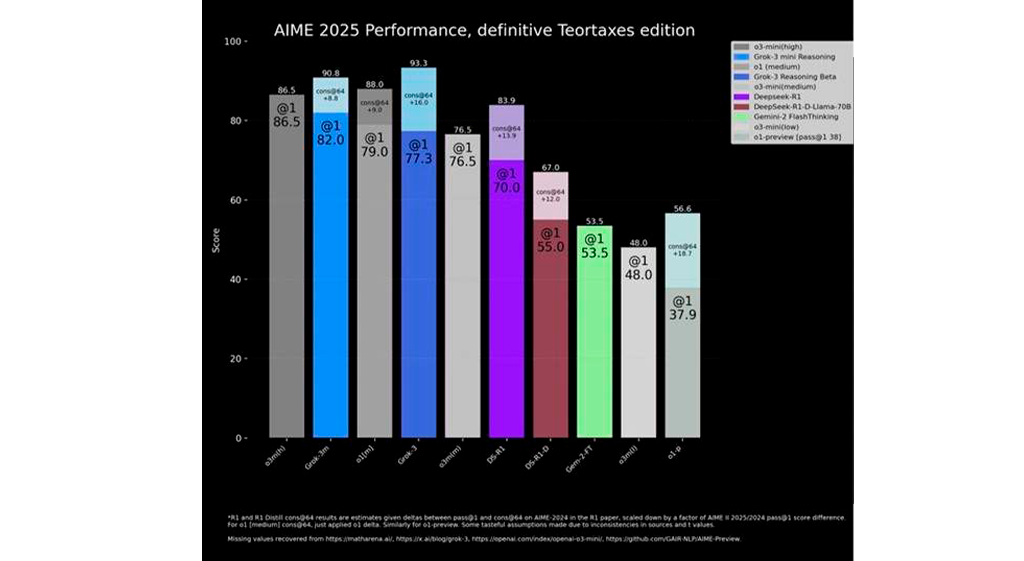

Solo Grok 3 incluye esta doble evaluación. ¿Por qué este criterio no es aplicado de manera uniforme en todos los modelos? En un artículo publicado en On Economía, el profesor de Esade Esteve Almirall, experto en IA e innovación, respondía: “porque así Grok 3 sale mejor en la foto”. Con un criterio unificado, el ranking quedaría así:

“Si solo tuviéramos en cuenta la primera respuesta, el resultado cambiaría por completo: ya no estaríamos ante el supuesto mejor modelo del mundo en matemáticas, sino ante un modelo competitivo que, a pesar de ser el más reciente, no supera a los líderes actuales”, añadía Almirall.

El problema de los benchmarks

La argucia con la que xAI intentó convencer al público de que su modelo era el mejor del mundo habla de una dinámica muy presente en el sector. Los benchmarks son pruebas estandarizadas que se utilizan para evaluar y comparar el rendimiento de modelos de IA, especialmente en tareas específicas como procesamiento de lenguaje natural, visión por ordenador, razonamiento, etc.

Estas pruebas se han vuelto más sofisticadas a medida que los modelos evolucionaban, pero eso no siempre significa que los usuarios finales se beneficien de mejoras relevantes. “Pocos usuarios participan en competiciones matemáticas de alto nivel o responden exámenes de doctorado en física o biología. En cambio, la mayoría quiere que la IA traduzca bien, responda correctamente y sea comprensible”, apunta Almirall.

Algunos modelos se diseñan para maximizar puntuaciones en pruebas en lugar de mejorar la experiencia de los usuarios

Y aunque los benchmarks cumplen una función muy importante —ofrecen una forma sintética de comprender el comportamiento de un modelo—, también tienen limitaciones.

“Cuando la propia herramienta de medición se convierte en el objetivo, el resultado puede ser engañoso”, escribe el profesor. “Cada vez más modelos de IA se entrenan pensando en los benchmarks y no en los usuarios. Esto ha llevado a la aparición de términos como ‘gaming the benchmarks’ o ‘cooking the benchmarks’, que describen prácticas en las que los modelos se diseñan para maximizar puntuaciones en pruebas en lugar de mejorar la experiencia real de los usuarios”.

Esta tendencia a optimizar las métricas no es exclusiva de la IA. En el ámbito financiero se conoce como ‘contabilidad creativa’ a la práctica poco ortodoxa de manipular las cifras financieras para dar una imagen más favorable. En algunos países, las estadísticas infladas para cumplir objetivos políticos han acuñado el término ‘fake GDP’. Y otro ejemplo ilustre es el de la ‘cocina’ de las encuestas electorales para favorecer a unos candidatos u otros.

¿Y qué ocurre con lo que no se mide?

Más allá de sus limitaciones técnicas, los benchmarks también suelen ignorar una dimensión cada vez más relevante en el desarrollo de la inteligencia artificial: la eficiencia.

En la carrera por obtener los mejores resultados en métricas estandarizadas, muchos modelos se construyen bajo la lógica del bigger is better, buscando aumentar la potencia a base de dedicar más recursos y capacidad de computación. Pero esta aproximación genera dudas sobre su sostenibilidad, tanto desde el punto de vista ambiental como el económico.

Como toda industria, la IA tendría debe someterse a controles de calidad, criterios de impacto y evaluaciones de eficiencia

El consumo de recursos necesario para entrenar y hacer funcionar los grandes modelos de lenguaje (LLMs) como Grok 3 o Chat GPT ha crecido de forma exponencial, mientras que las mejoras en su rendimiento son cada vez más marginales. Y en todo caso, los sistemas de evaluación actuales no miden cuánta agua, energía o materiales se necesitan para obtener una determinada puntuación. Para la profesora Irene Unceta, directora académica del Grado en Negocios e Inteligencia Artificial de Esade, “la industria de la IA, como cualquier otra, tendría que estar sometida a controles de calidad, criterios de impacto y evaluaciones de eficiencia”.

¿La mejor IA?

Pese a todo, hay algunos motivos para la esperanza. El último modelo de DeepSeek, desarrollado en China bajo importantes restricciones logísticas, anuncia la posibilidad de un cambio de paradigma. Su irrupción ha demostrado que es posible —y deseable— alcanzar resultados competitivos con un uso de recursos mucho más eficiente.

Responder a la pregunta de cuál es la mejor IA, por tanto, no solo consiste en acudir a los benchmarks. Implica conocer cuáles son las necesidades que tenemos como individuos y como sociedad, y qué coste estamos dispuestos a asumir para cubrirlas.

- Compartir en Twitter

- Compartir en Linked in

- Compartir en Facebook

- Compartir en Whatsapp Compartir en Whatsapp

- Compartir en e-Mail

¿Quieres recibir la newsletter de Do Better?

Suscríbite para recibir nuestro contenido destacado en tu bandeja de entrada..